Warum Künstliche Intelligenz keine Blackbox sein darf!

Warum sind Alexa, Siri und Cortana weiblich? Warum stammen Navigationsansagen im Auto stets von Frauen? Warum sind Sprachcomputer von Call-Centern, z. B. bei Banken oder Versicherungen, auch immer weiblich? Sind Frauen die idealen „Helfer“? Müssen wir „Helfer-Technologien“ automatisch dem weiblichen Geschlecht zuordnen? Das Problem: Menschliche Vorurteile, überholte Geschlechtervorstellungen und antiquierte Prägungen werden oft auch auf technologische Anwendungen übertragen. Oft unbewusst. Oft aber auch bewusst.

Mag dies bei digitalen Sprachassistenten einfach nur anachronistisch sein, ist es an anderer Stelle deutlich kritischer. Intelligente Maschinen beispielsweise lernen heute mit Methoden der Künstlichen Intelligenz (KI) eigene, neue Verhaltensregeln. Was genau ein KI-System dabei lernt, ist im Wesentlichen von den verwendeten Trainingsdaten abhängig – und diese können eben vorurteilsbehaftet bzw. von Vorurteilen geprägt sein. Stecken in Trainingsdaten Vorurteile, folgt auch das KI-System diesen Vorurteilen. Garbage in, Garbage out!

Beispiele diskriminierender KI

Dass KI-Systeme diskriminieren können, zeigt ein Beispiel von Google aus 2015. Google wollte damals mit Hilfe einer KI-Lösung Fotos in seinem Cloud-Fotodienst Google Fotos automatisch verschlagworten. Das klappte nicht so wie gedacht. So hatte die KI-Lösung Probleme, dunkelhäutige Menschen zu erkennen. In mindestens einem Fall wurden sie stattdessen als Gorillas bezeichnet bzw. verschlagwortet. Von einem ähnlichen Fall wird im Juni 2020 bei MSN.com berichtet, dem von Microsoft betriebenen Nachrichtenportal. Eine auf dem Portal eingesetzte KI-Software veröffentlichte einen Artikel der Zeitung „Independent“ über eine Sängerin der Popgruppe Little Mix. Die Sängerin heißt Jade Thirlwall. Ihre Großeltern mütterlicherseits stammen aus dem Jemen und Ägypten. Der Artikel thematisiert Thirlwalls Erfahrungen mit Rassismus. Die KI-Software illustrierte und ergänzte den Artikel allerdings mit einem Foto von Thirlwalls ebenfalls nicht-weißer Bandkollegin Leigh-Anne Pinnock. Daraufhin kritisierte die Sängerin Microsoft via Instagram: „Es beleidigt mich, dass ihr in einer Gruppe mit vier Mitgliedern die zwei women of colour nicht auseinanderhalten könnt. WERDET BESSER!„

Ein anderes Beispiel liefern Forscher um Aylin Caliskan von der Princeton University: Ein KI-System sollte anhand einer riesigen, frei verfügbaren Wortsammlung (dem „common crawl corpus“; bestehend aus mit 840 Milliarden Wörtern) lernen und definieren, welche Begriffe aus der Wortsammlung semantisch zusammengehören, also verwandt sind. Das Ergebnis: Das KI-System ordnete Blumen ebenso wie europäisch-amerikanische Vornamen oft positiven Begriffen zu. Insekten sowie afroamerikanische Namen wurden dagegen mit negativen Begriffen verbunden. Auch interessant: Männliche Namen standen für die KI semantisch näher an Karrierebegriffen, Mathematik und Wissenschaft. Weibliche Namen assoziierte sie eher mit Familie und Kunst. Das KI-System fällte also implizite Werturteile.

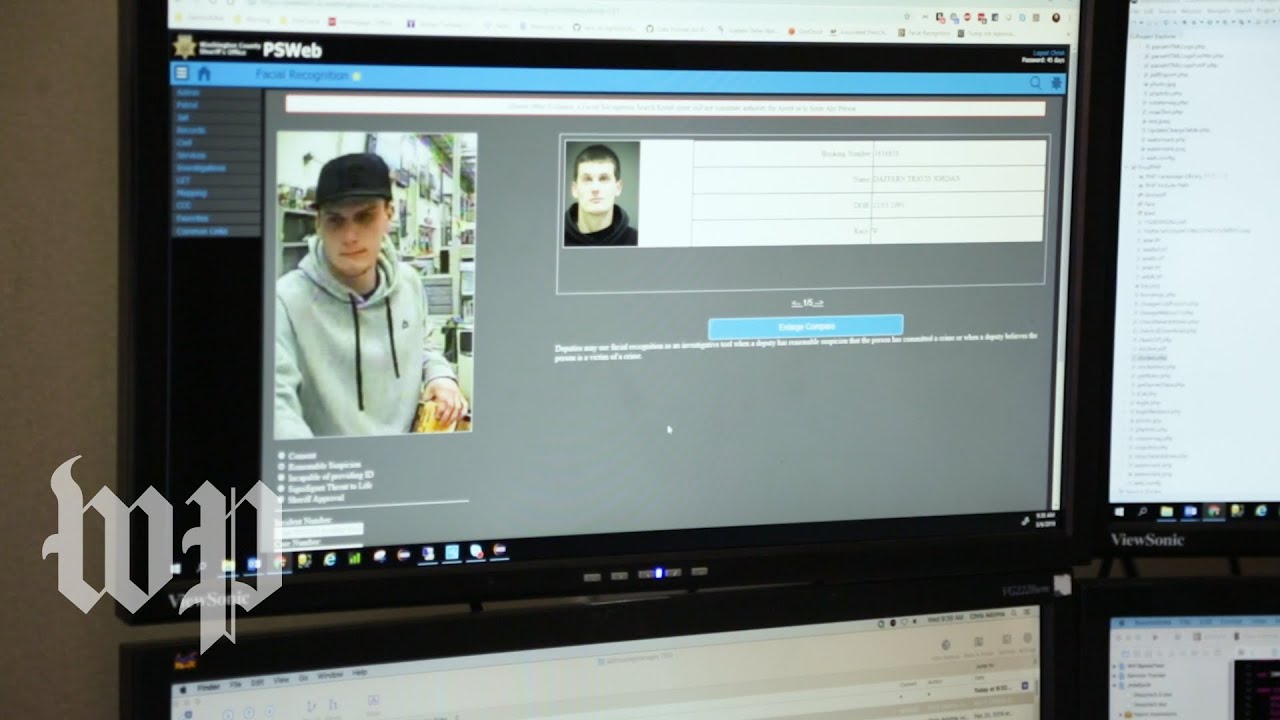

Auch Amazon arbeitet – wie viele globale Techkonzerne – an leistungsstarken KI-Systemen. Die REKOGNITION genannte Software wird von Amazon wie folgt beschrieben: „Amazon Rekognition erleichtert das Hinzufügen von Bild- und Videoanalysen zu Ihren Anwendungen mithilfe bewährter, hochgradig skalierbarer Deep Learning-Technologie, die keine Machine Learning-Kenntnisse erfordert. Mit Amazon Rekognition können Sie Objekte, Menschen, Text, Szenen und Aktivitäten in Bildern und Videos identifizieren sowie jegliche ungeeignete Inhalte erkennen. Amazon Rekognition bietet außerdem hochgenaue Gesichtsanalyse- und Gesichtssuchfunktionen, mit denen Sie Gesichter für eine Vielzahl von Benutzerüberprüfungen, Personenzählungen und Anwendungsfällen für die öffentliche Sicherheit erkennen, analysieren und vergleichen können.“ Einfach gesprochen: die Software kann Personen und Objekte in Fotos und Videos erkennen. Sie kann aber auch einzelne Personen in einer Gruppe von Menschen verfolgen und soll sogar Stimmungen anhand einer Gesichtsanalyse bestimmen können. Die Idee: So können Einzelhändler die Reaktionen ihrer Kunden (z. B. auf bestimmte Produkte) analysieren. Das Problem: Dieselbe Software kann aber auch aktiv als System zur Überwachung im öffentlichen Raum eingesetzt werden. Amazon warb sogar aktiv für solche Nutzungsszenarien. So könnte das System eine gesuchte Person in Echtzeit in großen Menschenmengen identifizieren. Zu den Kunden des Systems gehören neben dem Fotoportal Pinterest und der Navigationssoftware Here auch die Polizeidienststellen von Orlando und Washington County. Nach Berichten über fragwürdige Ergebnisse der Software erklärte Amazon im Juni 2020, dass er sein Programm ein Jahr lang nicht Polizeibehörden zur Verfügung stellen wird. Forscher hatten nach einer Testreihe berichtet und kritisiert, dass das Programm mehr Fehler bei Gesichtern mit einer anderen Hautfarbe als weiß mache. Der Staat solle zeitnah, so die Hoffnung von Amazon, einen regulierenden Rechtsrahmen für Gesichterkennungssoftware schaffen. Weiter zur Verfügung steht die Software allerdings Organisationen, die nach vermissten Kindern suchen, die Opfer von Menschenhändlern geworden sein könnten.

Video: Die Polizei nutzt Amazon’s Gesichterkennungssoftware REKOGNITION.

Ein weiteres Beispiel stammt ebenfalls aus den USA. Hier sollte eine Software, COMPAS (Correctional Offener Management Profiling for Alternative Sanctions) genannt, prognostizieren, wie hoch das potenzielle Rückfallrisiko von Strafgefangenen zum Zeitpunkt der Freilassung liegt. Richter sollten so besser entscheiden können, welche Gefangenen vor Ablauf der Strafe entlassen werden können. Eine sehr lesenswerte Recherche der Journalistenvereinigung ProPublica brachte dann zum Vorschein, dass die KI aus den verwendeten Trainingsdaten abgeleitet hatte, dass die Hautfarbe eines Menschen ein entscheidendes Merkmal für die prognostizierte kriminelle Energie ist. ProPublica untersuchte daraufhin manuell die von der KI vorgenommenen Bewertungen von über 7000 Strafgefangenen, die die Software als rückfallsgefährdet eingestuft hatte. Bei Gewaltverbrechern wurden 20% wie von der KI prognostiziert tatsächlich erneut straffällig. 80% aber eben nicht. Und das ist de facto diskriminierend. ProRepublica schreibt dazu: „When a full range of crimes were taken into account — including misdemeanors such as driving with an expired license — the algorithm was somewhat more accurate than a coin flip. Of those deemed likely to re-offend, 61 percent were arrested for any subsequent crimes within two years.“ Die Ergebnisse von ProPublica sind bedenkenswert! Entsprechend warnt auch der damalige amerikanischer Justizminister Eric Holder: „Although these measures were crafted with the best of intentions, I am concerned that they inadvertently undermine our efforts to ensure individualized and equal justice. They may exacerbate unwarranted and unjust disparities that are already far too common in our criminal justice system […].”

Ein letztes Beispiel aus den USA: Experimente haben gezeigt, dass Chatbots und Voice-Schnittstellen von Call-Center-Sprachcomputern nicht mit Dialekten zurechtkommen, die Afroamerikaner sprechen. Problematisch ist das deswegen, da dadurch Menschen von der Nutzung bestimmter Angebote ausgeschlossen werden, in diesem Fall Chatbots und Call-Center-Sprachcomputern. Die KI übernimmt also die menschliche Verhaltensweise, Vorurteile gegenüber anderen Menschen schon aufgrund deren Akzentes aufzubauen.

Viele weitere potenziell kritische Szenarien sind denkbar:

- KI hilft Personalabteilungen bei der Auswahl von Bewerbern (vgl. Video). Ein Beispiel stammt von Amazon: Der amerikanische E-Commerce-Konzern wollte Bewerbungen automatisch vorsortieren um geeignete Kandidaten zu selektieren. Allerdings: Die Software mochte keine Frauen. Auch hier lag das Problem, wie eine Analyse ergab, bei den verwendeten Trainingsdaten. Die KI-Lösung wurde anhand von Bewerbungen trainiert, die in den letzten zehn Jahren bei Amazon eingegangen waren. Die meisten dieser Bewerbungen stammten allerdings von Männern. Ein offensichtliches Muster, aus dem das KI-System folgerte, dass Männer bevorzugte Kandidaten waren.

https://www.facebook.com/gsohn/videos/10213759231406810/

Video: Interview mit Sven Semet, HR-Experte bei IBM.

-

- KI hilft Banken bei der Beurteilung der Kreditwürdigkeit von Kunden.

- KI hilft Krankenversicherern dabei, ungesund lebende Mitglieder zu erkennen.

- KI hilft Lebensversicherern dabei, gefährlich lebende Mitglieder zu erkennen.

- KI hilft Vereinen dabei, passende Mitglieder auszuwählen.

- KI entscheidet darüber, wer Zugang zu knappen Medikamenten erhält.

- KI hilft der Polizei, Verbrechen vorherzusagen (vgl. Video). Dass aber auch die Vorhersage von Verbrechen durch KI nicht der Weisheit letzter Schluss und fehleranfällig ist, zeigt die Studie von Dominik Gerstner vom Max-Planck-Institut für ausländisches und internationales Strafrecht, in der die Wirksamkeit der Predictive Policing Software Precobs untersucht wurde. Besagte Software wird auch in Deutschland genutzt um Einbrüche vorherzusagen.

Video: How cops are using algorithms to predict crimes.

Zwischenfazit

Das, was Maschinen lernen, muss erklärbar bleiben! Muss nachvollziehbar sein! KI-Lösungen müssen gewissenhaft mit qualitativ hochwertigen Trainingsdaten lernen, um sicherzustellen, dass nicht Vorurteile oder Befangenheit in ihre berechneten Ergebnisse Einzug halten. Wenn Menschen, Unternehmen und Gesellschaft nicht verstehen, wie eine KI-Software lernt, Muster erkennt und Ergebnisse analysiert, dann werden wir uns fragen, ob wir Maschinen wirklich trauen können. Gefragt ist also eine transparente KI.

Transparente vs. opaqe Künstliche Intelligenz

Grundsätzlich wird unterschieden zwischen transparenter und opaquer, also undurchsichtiger KI. Die Ergebnisse bzw. Berechnungen transparenter KI-Lösungen sind immer erklärbar und in jedem Schritt nachvollziehbar. Man kann immer feststellen, warum sich das KI-System wie verhält, also wie beispielsweise eine bestimmte Lösung zustande kommt. Opaque KI liefert dagegen Ergebnisse, von denen nicht mit Bestimmtheit gesagt werden kann, warum es dazu gekommen ist. Opaque KI lernt und formuliert eigene Regeln und ist eine Black Box.

Video: Machine learning and human bias.

Das Problem: Für Menschen ist es dann nicht mehr zwangsweise nachvollziehbar, wie die KI Entscheidungen trifft oder herleitet. Opaqe KI bedeutet die Kontrolle über die KI aufzugeben. Damit aber einer KI vertraut werden kann muss jede KI-Lösung aber die folgenden Fragen schlüssig und nachvollziehbar beantworten:

- Warum hat die KI gehandelt wie sie gehandelt hat?

- Warum hat die KI nicht eine alternative Vorgehensweise ausgewählt?

- Wann betrachtet eine KI eine Handlung als Erfolg? Wann als Misserfolg?

- Wie kann der Mensch Fehler erkennen und korrigieren?

- Kann man der KI wirklich vertrauen?

Intensiv wird heute darüber diskutiert, wie wir Menschen dafür Sorge tragen können, dass KI immer erklärbar ist. Dafür hat sich sogar ein eigener Begriff etabliert: Explainable Artificial Intelligence (XAI).

Erklärbare KI – Explainable Artificial Intelligence (XAI)

Brandaktuell (September 2018) eingeführt hat IBM sein AI Fairness 360 Degree Toolkit. Das Open Source Tool erlaubt Entwicklern von KI-Lösungen verwendete Trainingsdaten auf unerkannte und unerwünschte, d. h. ggf. diskriminierende und vorurteilsbehaftete Daten zu durchsuchen: „This initial release of the AIF360 Python package contains nine different algorithms, developed by the broader algorithmic fairness research community, to mitigate that unwanted bias.“

Auch andere Tech-Konzerne folgen. Laut einem Bericht von MIT Technology Review arbeitet Microsoft an einem Tool beziehungsweise Dashboard, das automatisiert „unfaire“ beziehungsweise „diskriminierende“ KI-Algorithmen erkennen kann. Facebook hat zuletzt auf seiner Entwicklerkonferenz angekündigt, an einem entsprechenden Tool, genannt „Fairness Flow“, zu arbeiten. Auch das Beratungsunternehmen Accenture entwickelt ein „AI Fairness Tool“, das KI-Anwender dabei unterstützt, von ihnen eingesetzte Algorithmen auf „Fairness“ zu überprüfen – also daraufhin, ob sie Menschen grundsätzlich gerecht behandeln.

Im amerikanischen Verteidigungsministerium bündelt ein eigenes Projekt entsprechende Aktivitäten (vgl. Video): „The Explainable AI (XAI) program aims to create a suite of machine learning techniques that: Produce more explainable models, while maintaining a high level of learning performance (prediction accuracy); and Enable human users to understand, appropriately trust, and effectively manage the emerging generation of artificially intelligent partners.”

Video: A DARPA perspective on Artificial Intelligence.

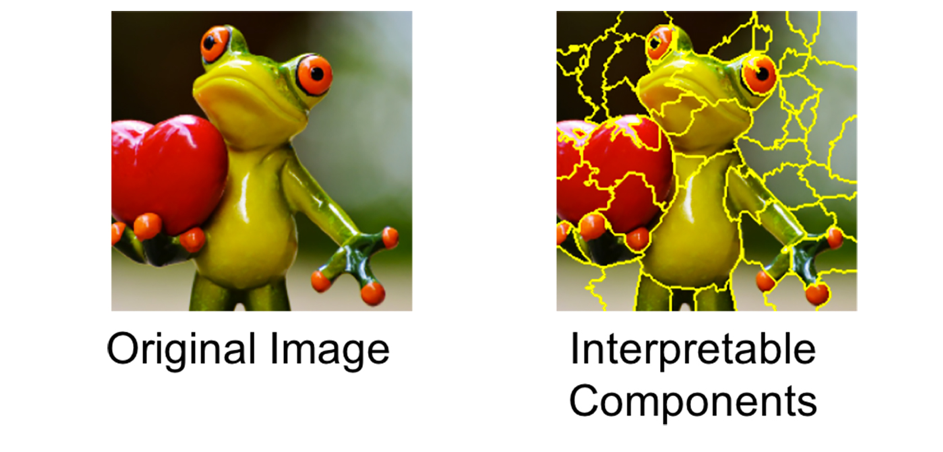

Auch Forscher beschäftigen sich mit entsprechenden, oft spezielleren Ansätzen: Das sehr spezielle Problem erklärbarer und nachvollziehbarer Bildklassifikationen adressieren Lisa Anne Hendricks und ihre Kollegen in ihrem spannenden Artikel „Generating Visual Explanations“. Im Grunde geht es um die gleiche Thematik wie bei den Forschern um Aylin Caliskan von der Princeton University und ihrem „common crawl corpus“ (siehe oben) – nur jetzt eben bezogen auf Bilder. Die Idee: Werden Bilder von einer KI-Lösung verarbeitet und klassifiziert, wird von der KI – zusätzlich zur Klassifikation selbst – eine Erklärung generiert, die die vorgenommene Klassifikation visuell begründet und damit erklärbar macht. Ein anderer, sehr allgemeiner Ansatz für die Nachvollziehbarkeit von KI-Klassifikationen ist LIME (Local Interpretable Model-Agnostic Explanations), entwickelt von Marco Tulio Ribeiro, Sameer Singh und Carlos Guestrin. Das zu klassifizierende Objekt, z. B. ein Bild, wird in einzelne Bestandteile zerlegt (vgl. nachfolgende Abbildung) – die dann einzeln analysiert und klassifiziert werden. Unbedeutendes Rauschen wird so quasi vom relevanten Inhalt getrennt. Dadurch soll es dann eben einfacher zu begründen sein, warum eine Software bestimmte Klassifizierungen vornimmt oder eben auch nicht.

Abbildung: Bildzerlegung in Komponenten. (Quelle: M. T. Ribeiro).

Fazit

Was genau ein KI-System lernt, ist im Wesentlichen von verwendeten Trainingsdaten abhängig. Diese können vorurteilsbehaftet bzw. von Vorurteilen geprägt sein. Notwendig ist es deswegen, KI erklärbar zu machen. Warum hat die KI gehandelt wie sie gehandelt hat? Nur dann kann KI-Lösungen wirklich vertraut werden.