Deep Learning + Fake = Deep Fake

Barack Obama beschimpft Donald Trump: „President Trump is a total and complete Dipshit“ (vgl. Video). Donald Trump fordert in einem anderen Video die Wähler Belgiens auf, einer Partei die Stimme zu geben, die für den Austritt aus dem Pariser Klimaabkommen ist: „As you know, I had the balls to withdraw from the Paris climate agreement – and so should you“. Berühmte weibliche Hollywood-Stars spielen plötzlich in pornographischen Filmen mit. Facebook-Gründer Mark Zuckerberg philosophiert über „die gestohlenen Daten von Milliarden Menschen“ und eine mögliche Facebook-Weltherrschaft: „Stellt euch das mal kurz vor: Ein Mann, mit totaler Kontrolle über die gestohlenen Daten von Milliarden Menschen, alle ihre Geheimnisse, ihr Leben, ihre Zukunft – ich schulde das alles Spectre. Spectre hat mir gezeigt, dass derjenige, der die Daten kontrolliert, auch die Zukunft kontrolliert.“ Alles denkbar! Aber alles Fälschungen! Nicht einfach nur mehr oder weniger schlecht gemachte, sondern täuschend echt wirkende Fälschungen realer Personen. Mit Hilfe von Künstlicher Intelligenz (KI) erstellte Fälschungen: DEEP FAKE!

Video: Barack Obama beschimpft Donald Trump.

Video: Marc Zuckerberg sinniert über die Weltherrschaft.

Was ist Deep Fake?

Mit Deep Fake werden gefälschte, aber täuschend echt wirkende Bilder oder Videos von realen Personen bezeichnet. Der Begriff „Deep Fake“ setzt sich aus den Schlagworten „Deep Learning“ (einer Technik im Bereich der Künstlichen Intelligenz) und „Fake“ (also Fälschung) zusammen und beschreibt die Erstellung manipulierter audio-visueller Inhalte, v. a. von Videos. Meist geht es darum, menschliche Gesichter, z. B. von Politikern oder Prominenten, auf andere Körper zu setzen oder um die realistische Simulation der Sprache, Gestik und Mimik von Personen. Erreicht wird dies mit Techniken aus dem Bereich der KI, die ursprünglich zum Zwecke der Gesichts- oder Objekterkennung entwickelt wurden.

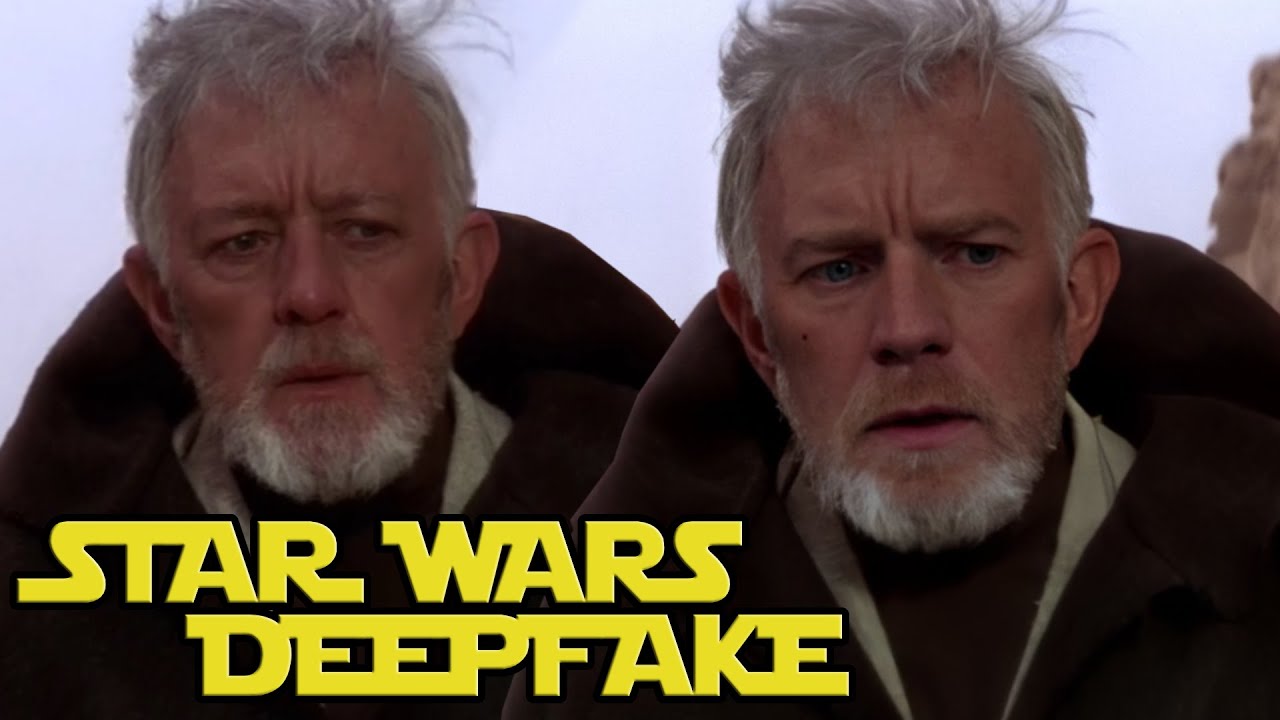

Video: Ewan McGregor als Obi-Wan Kenobi.

Betroffen sind bislang v. a. Politiker (kritisch ist eigentlich der ganze Bereich der Politik und demokratischer Meinungsbildungsprozesse z. B. bei Wahlen) oder Prominente. Aber auch kreative Videos sind möglich. So wurde z. B. in einem Deep-Fake-Video dafür gesorgt, dass Obi-Wan Kenobi aus den älteren Filmen, also Alec Guinness, die Rolle mit dem Obi-Wan aus der Prequel-Trilogie tauscht. So wird aus Guinness kurzerhand ein Ewan McGregor in der klassischen Trilogie. Das Ergebnis ist gleichermaßen beängstigend, als auch bemerkenswert. Für Aufsehen sorgte auch ein Deep Fake Video der New York Times mit der britischen Sängerin Adele.

Video: Deep Fake Beispiel der New York Times mit Adele.

Betroffen können aber wir alle sein. Software, um Deep Fakes innerhalb von Minuten zu erzeugen, z. B. die Applikation Fake-App, gibt es bereits heute kostenlos zum Download. Auch Menschen, die nicht im Rampenlicht stehen, können so schnell mit DeepFakes konfrontiert sein. Besonders gefährdet sind dabei, so zeigen Beispiele, v. a. Frauen, Minderheiten und Menschen, die sich sowieso unreflektiertem Hass ausgesetzt sehen. Zuletzt sorgte in den USA die App DeepNude für Entsetzen. Ein anonymer Entwickler hatte die KI-App bereitgestellt, die zu beliebigen Gesichtern von Frauen realistisch aussehende, aber gefälschte nackte Körper erzeugte. „Revenge Porn“, Mobbing und eheverletzendem Verhalten wird so Tür und Tor geöffnet. In Indien wurde z. B. das Gesicht einer Journalistin, die kritisch über eine Lokalbehörde berichtet hatte, in ein Pornovideo montiert. In China sorgte zuletzt (August 2019) die App ZAO für Staunen und Aufregung. Die Software erlaubt es Nutzern, Hollywood- und Popstars in kurzen Videoclips ihr eigenes Gesicht digital „überzuziehen“. Um die Hauptrolle in Spielfilmen und Musikvideos zu übernehmen muss der App lediglich ein Selfie übergeben werden. Der Entwickler der App, Allan Xia, hat zu Demonstrationszwecken sein Gesicht in eine Serie von Filmszenen mit Leonardo DiCaprio montieren lassen. Die DeepFake-Sequenz, so Via, soll in weniger als acht Sekunden von der App erzeugt worden sein.

Viele Missbrauchsszenarien

Deep Fake Manipulationen können also dramatische Folgen haben. Viele Missbrauchsszenarien sind denkbar: die Manipulation von privaten Videoaufnahmen, die Fälschung von Unfallaufnahmen, oder die Manipulation von Videos aus Kriegs- und Krisengebieten.

Das Problem: Deep Fakes können, da es um audiovisuelle Fälschungen geht, eine andere Wirkmacht entfalten als textuelle Fake News. Dazu sagt Danielle Citron, Jura-Professorin an der University of Maryland in einem Artikel im The Guardian: „The marketplace of ideas already suffers from truth decay as our networked information environment interacts in toxic ways with our cognitive biases. Deep fakes will exacerbate this problem significantly.“ Tim Hwang, Direktor der “Harvard-MIT Ethics and Governance of Artificial Intelligence Initiative” wird im gleichen Artikel zitiert: “We have long been able to doctor images and movies, but in the past, if you wanted to make a video of the president saying something he didn’t say, you needed a team of experts. Machine learning will not only automate this process, it will also probably make better forgeries.”

Ebenfalls in den Fokus rückt zunehmend die Befürchtung, dass ganz normale Kriminelle per App generierte DeepFakes nutzen könnten, um sich Zugang zu Bankkonten oder anderen angreifungswürdigen Services zu verschaffen. Aus England ist bereits ein Beispiel bekannt. Dort wurde ein Energieanbieter um über 200.000€ betrogen. Was war passiert? Der Chef des englischen Unternehmens telefonierte mit seinem eigenen Vorgesetzten, dem Geschäftsführer des deutschen Mutterkonzerns. In Wirklichkeit telefonierte er jedoch mit einem Betrüger, der mittels der Deepfake App Zao die Stimme des CEO perfekt mit Stimmlage und Akzent imitierte. Der Betrüger wies den Engländer an, eine Überweisung von 220.000€ an einen ungarischen Zulieferer vorzunehmen. Der Manager tat wie ihm geheißen. Als der Betrug nach weiteren Fake-Anrufen aufflog, war das Geld längst von Ungarn aus auf einem mexikanischen Konto gelandet und verloren.

Zur Wirkmacht von Deep Fake

Als Brandbeschleuniger für den gezielten Einsatz von Deep Fakes können insbesondere soziale Medien dienen, deren Funktionsprinzip den impulsiven Teil unseres menschlichen Gehirns anspricht, also den Teil, der Dingen Aufmerksamkeit schenkt, die unser Verstand normalerweise ignoriert: Katzenvideos, lustige Memes, aber eben auch Hass, Manipulation und öffentliche Bloßstellung.

Video: Deepfake Videos Are Getting Real and That’s a Problem.

Notwendig und geboten ist eine Auseinandersetzung mit den ethisch-moralischen Folgen von DeepFakes. Dazu Sam Gregory, Direktor der Menschenrechtsorganisation Witness (bezogen auf die App DeepNude; siehe oben): “Technology is not neutral. This [DeepNude] app is not dual use. It’s single use for a malicious purpose, and it is being created amorally. We need to really focus on the ethics of creating and sharing generative media tools. We should repeatedly call this out.”

Die Wirkmacht von Deep Fakes ist HEUTE per se relativ gering. Zu irre und selbstentlarvend sind viele Beispiele. In Zeiten, in denen oft nicht mehr klar ist, ob etwas real oder Fiktion/Satire ist, wird aber auch dieses Argument einer fortlaufenden Prüfung unterzogen. Die Situation und Anwendungsszenarien können MORGEN schon eine ganz andere sein. Dazu ein Beispiel: Die beiden Wissenschaftler Joseph Bullock und Miguel Luengo-Oroz zeigen in ihrem lesenswerten Paper „Automated Speech Generation from UN General Assembly Statements: Mapping Risks in AI Generated Texts“ wie sie mit Hilfe von Open-Source-Tools ein Text-Generator gebaut werden kann, der fiktive Reden für die UN-Hauptversammlung erzeugen und simulieren kann. Dazu nutzten Sie ein existierendes Modell zur Spracherzeugung und trainierten dieses gerade einmal 13 Stunden lang mit allen Reden, die seit 1970 in der UN-Hauptversammlung gehalten wurden. Zwar geht es hier noch nicht um Video – das erschreckende Potenzial wird aber deutlich. Auch Internetkonzerne haben die drohende Gefahr mittlerweile erkannt. Facebook hat in der Folge Anfang 2020 in einem Blog-Eintrag Regeln für den Umgang mit manipulierten Videos bekannt gegeben. So sollen Deep Fakes gelöscht werden, wenn sie so gut gemacht sind, dass die Manipulation nicht auffällt. Erlaubt sind dagegen weiter Videos, bei denen lediglich die Qualität des Videos an sich verbessert wird oder bei denen die Manipulation einen satirischen Charakter hat. Auch die deutsche Bundesregierung sorgt sich: „Deep Fakes können eine große Gefahr für Gesellschaft und Politik darstellen, wenn sie dazu genutzt werden, die öffentliche Meinung zu manipulieren und den politischen Prozess gezielt zu beeinflussen„, schreibt sie in einer Antwort auf eine Anfrage der FDP-Bundestagsfraktion. Weiter: „Es kann nicht ausgeschlossen werden, dass aufgrund der schnellen technologischen Fortschritte künftig auch eine Bedrohung demokratischer Prozesse durch Deep Fakes erfolgen kann.“

Fast schon blauäugig und naiv scheint da die Aussage der New York Times zu sein: “It is possible, however, that some good will come out of the deep fakes menace. Maybe we will better understand that the truth is both precious and endangered. Perhaps we will learn to pause before giving in to internet-stoked spleen. Above all, we have to more fiercely call out and refute manipulative liars — as well as the people who insist on believing their fictions.”