Mensch und Maschine: Kontrolle außer Kontrolle

Schon heute ist es längst in unserem Alltag zu beobachten: Nicht mehr Menschen, sondern Algorithmen und Maschinen treffen Entscheidungen. Über die Vergabe von Bankkrediten. Über die schnellste Fahrroute in den Urlaub. Darüber, welche Werbung wir online sehen. Aber auch in unter Umständen lebensbedrohlichen Situationen nehmen Algorithmen und Maschinen zunehmend das Heft in die Hand. So entscheiden Algorithmen über das Einleiten von Notfallbremsmanövern von Autos. Algorithmen lenken Flugzeuge durch gefährliche Wetterlagen. Autonome tödliche Waffensysteme, z. B. Drohnen, entscheiden selbständig über Leben und Tod auf den Schlachtfeldern der Welt.

Je gravierender die Konsequenzen von Entscheidungen und Handlungen von Algorithmen und Maschinen sind, desto größer wird dabei ein Problem: Algorithmen und Maschinen können per se mit Uneindeutigkeit nicht umgehen. Ambivalenz ist für Maschinen kein intuitives Konzept. Maschinen folgen deterministischen Handlungsvorgaben, den Algorithmen, mit denen sie programmiert wurden. Gerade in Situationen, in denen es um Leben und Tod geht, ist Ambivalenz aber oft die Regel, nicht die Ausnahme. Besonders gilt dies für das Beispiel digitalisierter Kriegsführung: Wie wird beispielsweise entschieden, ob ein intelligentes Waffensystem schießt oder nicht? Wie unterscheidet ein Waffensystem zwischen einer Kampfsituation und einer Gefechtspause? Wie zwischen gegnerischen Waffensystemen und gegnerischen Soldaten? Wie zwischen fremden Soldaten und Zivilisten?

Tatsächlich stellt sich – aufbauend auf diesen Überlegungen – schnell die Frage, ob und wie im Kontext zunehmend autonom handelnder Maschinen der Mensch noch die Kontrolle über die Entscheidungen und das Verhalten von Maschinen hat.

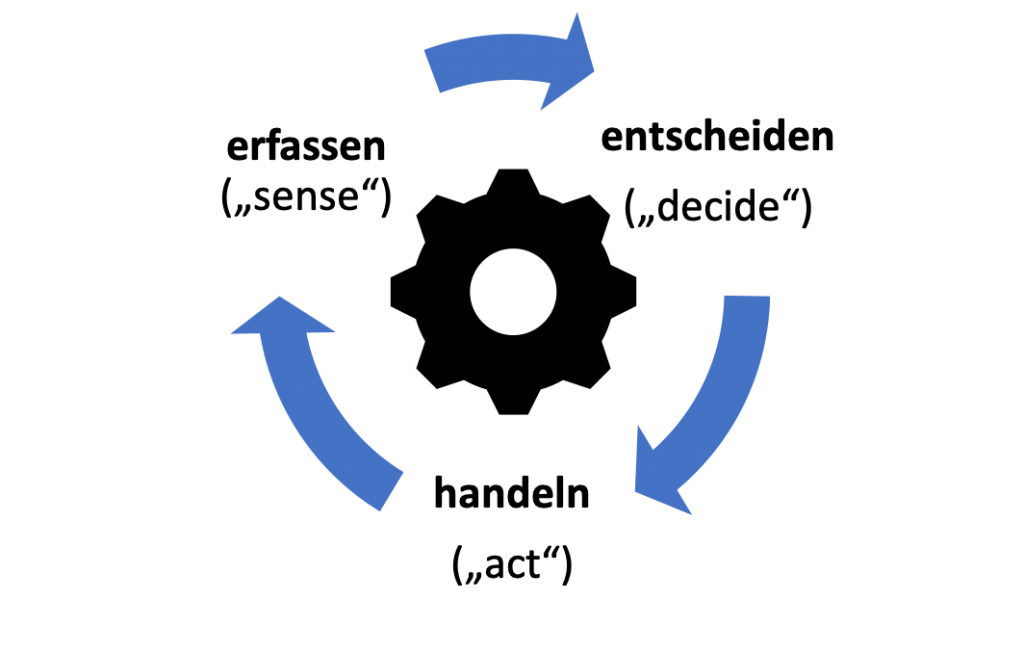

Zur Beschreibung verschiedener Kontrollszenarien wird typischerweise der „sense-decide-act“-Zyklus (vgl. Abbildung 1) verwendet. Die Idee ist einfach: Menschen oder Maschinen beobachten und erfassen die eigene Umwelt, entscheiden dann anhand der beobachteten bzw. erfassten Situation und führen schließlich eine Handlung aus.

Abbildung 1: Erfassen – entscheiden – handeln (angelehnt an [1, S. 28]).

Dazu wie dieser Zyklus jetzt im Spannungsfeld der Maschinenkontrolle durch den Menschen aussieht, gibt es nun verschiedene Varianten:

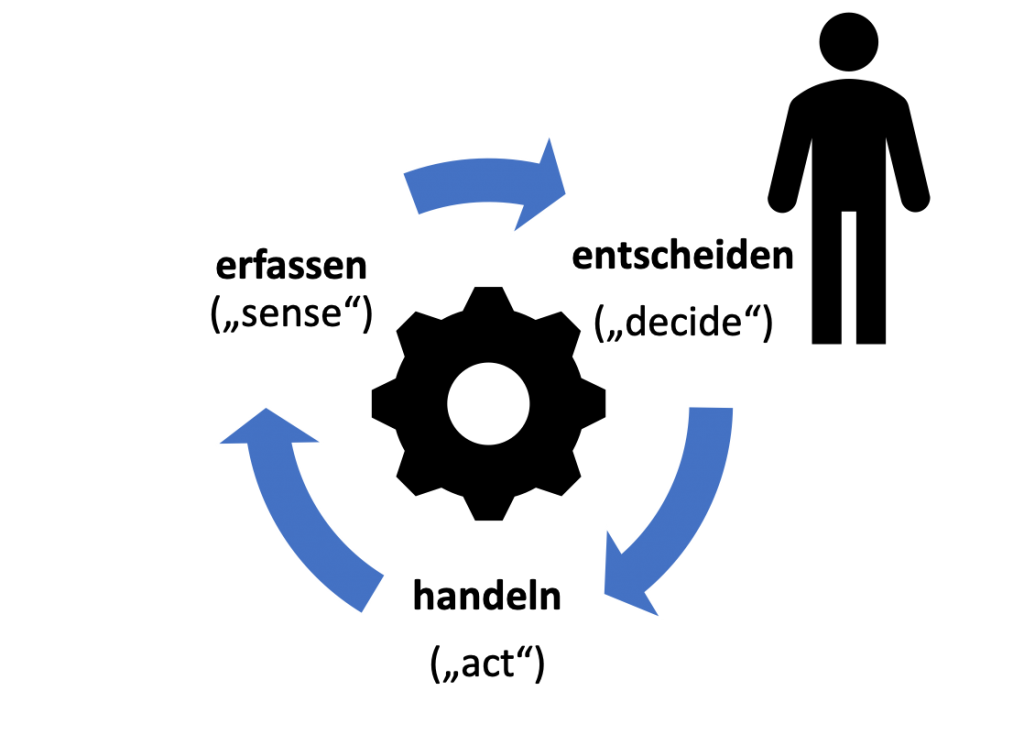

Human IN the Loop

Als „human in the loop“ werden Szenarien bezeichnet, bei denen immer ein Mensch entscheidet, ob eine Maschine tatsächlich handeln soll (vgl. Abbildung 2). Das heißt, die Maschine ist für die Beobachtung und Erfassung der Umwelt („sense“) und auch die Ausführung einer Handlung („act“) zuständig. Ob aber tatsächlich gehandelt werden soll, entscheidet immer ein Mensch („decide“). Die Handlungsfreigabe erfolgt also immer durch einen Menschen. Man spricht deswegen auch von semiautonom handelnden Maschinen.

Abbildung 2: Human IN the loop (angelehnt an [1, S. 29]).

Ein Beispiel eines „human in the loop“-Szenarios sind Anpassungen der Konfiguration von großen komplexen Maschinen, z. B. von Turbinen in Kraftwerken. Anhand permanent überwachter Funktionsparameter der Turbine schlägt die Steuerungssoftware der Turbine eine Anpassung der eigenen Konfiguration vor, um z. B. effizienter zu funktionieren. Ob die Konfiguration angepasst wird entscheidet dann aber ein menschlicher Kraftwerksmitarbeiter.

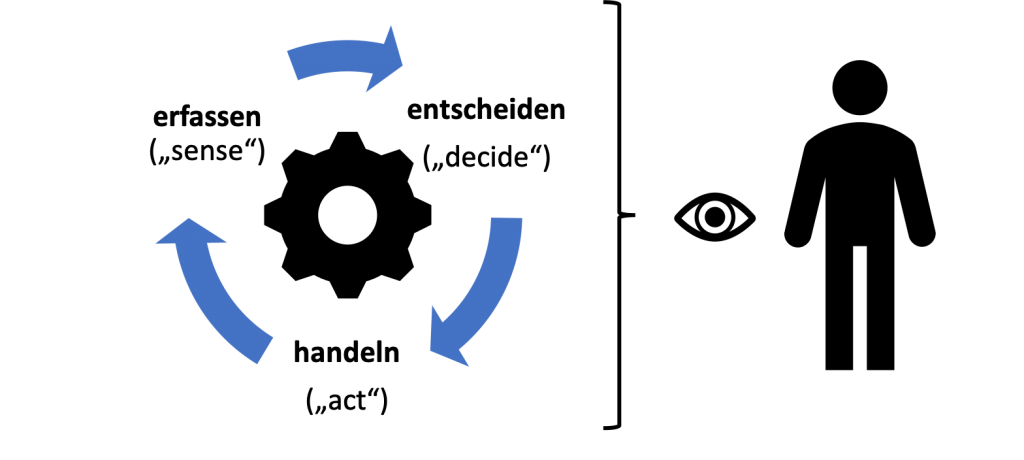

Human ON the Loop

Als „human on the loop“ werden Szenarien bezeichnet, bei denen eine Maschine selbständig die Umwelt erfasst und beobachtet, aufgrund der erfassten bzw. beobachteten Situation dann entscheidet zu handeln und schließlich auch tatsächlich handelt (vgl. Abbildung 3). Einem Menschen kommt hier nur mehr die Rolle eines Überwachers („supervisers“) zu, der die Maschine beobachtet und ggf. intervenieren kann. Man spricht in diesem Fall auch von überwachten autonomen Handlungen einer Maschine.

Abbildung 3: Human ON the loop (angelehnt an [1, S. 29]).

Von einem „human on the loop“-Szenario spricht man allerdings nur dann, wenn der Mensch die realistische Chance hat tatsächlich steuernd einzugreifend. Ist dies nicht der Fall, ist der Mensch nicht mehr „on the loop“, sondern „out oft he loop“ (vgl. nächster Abschnitt).

Ein einfaches Beispiel eines „human on the loop“-Szenarios ist der Einsatz eines Staubsaugerroboters. Ein solcher Roboter erfasst („sense“) seine Umwelt und saugt („act“) dann autonom („decide“) innerhalb vorhandener Grenzen (Raumwände, Teppichkanten etc.). Der Mensch kann die Funktionsweise der Maschine überwachen und ggf. eingreifen, z. B. wenn der Staubsaugerroboter stecken bleibt und nicht mehr weiterarbeiten kann.

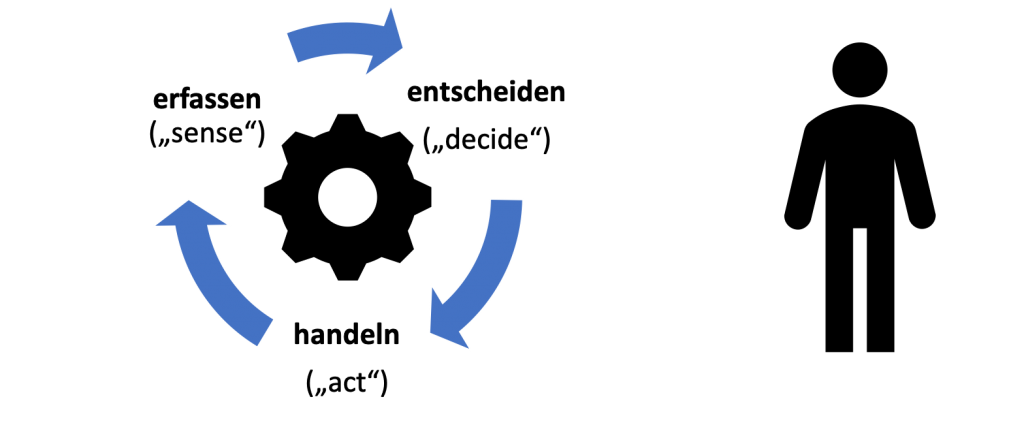

Human OUT OF the Loop

Als „human out of the loop“ werden schließlich Szenarien bezeichnet, bei denen die Maschine völlig selbständig die Umwelt erfasst und beobachtet, aufgrund der beobachteten Situation entscheidet zu handeln und dann auch tatsächlich handelt (vgl. Abbildung 4). Im Unterschied zum vorhergehenden „on-the-loop“-Szenario ist es hier einem Menschen aber nicht mehr möglich, die Handlungen der Maschine aufzuhalten.

Abbildung 4: Human OUT OF the loop (angelehnt an [1, S. 30]).

Ein Beispiel ist das Waffensystem „Phalanx Mk-15“ von Raytheon, ein US-amerikanisches Nahbereichsverteidigungssystem zur Abwehr anfliegender Flugkörper. Das System ist auf fast jedem Schiff der US Navy installiert und besteht aus einem Radar und einer Kanone. Das die Kanone leitende Radar befindet sich direkt über dem Geschütz und ermittelt automatisch und exklusiv für die Kanone die Ziele, auf die geschossen werden soll. Das System agiert völlig autonom und verteidigt auch dann noch das Schiff, wenn die Gefechtsleitzentrale bereits ausgefallen ist. Hat das System einmal ein Ziel erfasst ist es Menschen nicht mehr möglich einzugreifen und z. B. den Angriff auf ein Ziel abzubrechen.

YouTube-Video: Das Phalanx Mk-15-Waffensystem.

Es dreht sich alles im Vertrauen!

Der Grad an Autonomie, den man als Mensch einer Maschine zugesteht, hängt insbesondere mit dem Vertrauen zusammen, den man als Mensch in die Entscheidungen der Maschine hat. Grundvoraussetzung für Vertrauen ist dabei, dass eine Maschine mit an Sicherheit grenzender Wahrscheinlichkeit das tut, was sie eben tun soll, dass also ihr Verhalten der menschlichen Erwartungshaltung entspricht. Dabei bedeutet Vertrauen jedoch kein blindes Vertrauen. Vertrauen bedeutet vielmehr die Fähigkeiten und die Grenzen einer Maschine zu kennen und zu verstehen. Dass dies nicht immer einfach umzusetzen ist, wurde schon an anderer Stelle in diesem Blog thematisiert.

Quellen

[1] Paul Scharre: „Army of None“. WW Norton & Co, 2019.